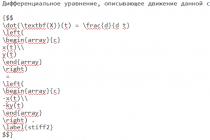

Собственно, хочется просто и доступно рассказать про такую замечательную вещь как Logical Volume Management или Управление Логическими Томами.

Поскольку уже давно пользуюсь LVM-ом, расскажу что он значит именно для меня, не подглядывая в мануалы и не выдёргивая цитаты из wiki, своими словами, чтобы было понятно именно тем кто ничего о нем не знает. Постараюсь сразу не рассказывать о всяческих «продвинутых» функциях типа страйпов, снапшотов и т.п.

LVM - это дополнительный слой абстракции от железа, позволяющий собрать кучи разнородных дисков в один, и затем снова разбить этот один именно так как нам хочется.

Есть 3 уровня абстракции:

1. PV (Physical Volume) - физические тома (это могут быть разделы или целые «неразбитые» диски)

2. VG (Volume Group) - группа томов (объединяем физические тома (PV) в группу, создаём единый диск, который будем дальше разбивать так, как нам хочется)

3. LV (Logical Volume) - логические разделы, собственно раздел нашего нового «единого диска» ака Группы Томов, который мы потом форматируем и используем как обычный раздел, обычного жёсткого диска.

это пожалуй вся теория. :) теперь практика:

для работы нужны пакеты lvm2 и возможность работать с привелегиями root поэтому:

$ sudo bash

# apt-get install lvm2

Допустим у нас в компе есть жёсткий диск на 40Гб и нам удалось наскрести немного денег и наконец-то купить себе ТЕРАБАЙТНИК! :))) Система уже стоит и работает, и первый диск разбит одним разделом (/dev/sda1 как /), второй - самый большой, который мы только подключили - вообще не разбит /dev/sdb…

Предлагаю немножко разгрузить корневой диск, а заодно ускорить (новый диск работает быстрее старого) и «обезопасить» систему с помощью lvm.

Можно делать на втором диске разделы и добавлять их в группы томов (если нам нужно несколько групп томов),

а можно вообще не делать на диске разделы и всё устройство сделать физическим разделом (PV)

Root@ws:~# pvcreate /dev/sdb

Physical volume "/dev/sdb" successfully created

Создаём группу томов с говорящим названием, например по имени машины «ws», чтобы когда мы перетащим данный диск на другую машину небыло конфликтов с именами групп томов:

Root@ws:~# vgcreate ws /dev/sdb

Желательно внести с корневого раздела такие папки как /usr /var /tmp /home, чтобы не дефрагментировать лишний раз корневой раздел и ни в коем случае его не переполнить, поэтому создаём разделы:

Root@ws:~# lvcreate -n usr -L10G ws # здесь мы создаём раздел с именем «usr», размером 10Gb

Logical volume «usr» created

по аналогии делаем то же для /var, /tmp, /home:

root@ws:~# lvcreate -n var -L10G ws

root@ws:~# lvcreate -n tmp -L2G ws

root@ws:~# lvcreate -n home -L500G ws

у нас ещё осталось немного свободного места в группе томов (например для будущего раздела под бэкап)

посмотреть сколько именно можно командой:

root@ws:~# vgdisplay

информацию по созданным логическим томам

root@ws:~# lvdisplay

информацию по физическим томам

root@ws:~# pvdisplay

Разделы что мы создали появятся в папке /dev/[имя_vg]/, точнее там будут ссылки на файлы,

lrwxrwxrwx 1 root root 22 2009-08-10 18:35 swap -> /dev/mapper/ws-swap

lrwxrwxrwx 1 root root 21 2009-08-10 18:35 tmp -> /dev/mapper/ws-tmp

lrwxrwxrwx 1 root root 21 2009-08-10 18:35 usr -> /dev/mapper/ws-usr

lrwxrwxrwx 1 root root 21 2009-08-10 18:35 var -> /dev/mapper/ws-var

и т.д…

Дальше lvm уже почти кончается… форматируем наши разделы в любимые файловые системы:

root@ws:~# mkfs.ext2 -L tmp /dev/ws/tmp

root@ws:~# mkfs.ext4 -L usr /dev/ws/usr

root@ws:~# mkfs.ext4 -L var /dev/ws/var

root@ws:~# mkfs.ext4 -L home /dev/ws/home

Кстати, не плохо было бы сделать раздел подкачки:

root@ws:~# lvcreate -n swap -L2G ws

root@ws:~# mkswap -L swap /dev/ws/swap

root@ws:~# swapon /dev/ws/swap

Создаём папку и подключая по очереди новообразовавшиеся тома, копируем в них нужное содержимое:

root@ws:~# mkdir /mnt/target

root@ws:~# mount /dev/ws/home /mnt/target

копируем туда всё из папки /home своим любимым файловым менеджером (с сохранением прав доступа), например так;):

root@ws:~# cp -a /home/* /mnt/target/

root@ws:~# umount /mnt/target/

кстати, для папки temp необходимо только поправить права, копировать туда что-либо необязательно:

root@ws:~# mount /dev/ws/tmp /mnt/target && chmod -R a+rwx /mnt/target && umount /mnt/target/

добавляем нужные строчки в /etc/fstab, например такие:

/dev/mapper/ws-home /home ext4 relatime 0 2

/dev/mapper/ws-tmp /tmp ext2 noatime 0 2

/dev/mapper/ws-swap none swap sw 0 0

и перезагружаемся… (продвинутые господа могут обойтись без перезагрузки;))

На вкусное, хочу предложить более продвинутую штуку:

допустим у нас есть система с разделом на LVM, а жёсткий диск начал сбоить, тогда мы можем без перезагрузки переместить всю систему на другой жёсткий диск/раздел:

# On-line добавление/удаление жёстких дисков с помощью LVM (пример)

Root@ws:~# pvcreate /dev/sda1 # наш эмулятор сбойного диска

Physical volume "/dev/sda1" successfully created

Root@ws:~# pvcreate /dev/sdb1 # наш эмулятор спасательного диска

Physical volume "/dev/sdb1" successfully created

Root@ws:~# vgcreate vg0 /dev/sda1 # создаю группу томов vg0

Volume group «vg0» successfully created

Root@ws:~# lvcreate -n test -L10G vg0 #создаю раздел для «важной» инфы

Logical volume «test» created

Root@ws:~# mkfs.ext2 /dev/vg0/test # создаю файловую систему на разделе

root@ws:~# mount /dev/mapper/vg0-test /mnt/tmp/ #монтирую раздел

… # заполняю его информацией, открываю на нем несколько файлов и т.п.

Root@ws:~# vgextend vg0 /dev/sdb1 # расширяю нашу групу томов на «спасательный» диск

Volume group «vg0» successfully extended

Root@work:~# pvmove /dev/sda1 /dev/sdb1 #передвигаю содержимое с «умирающего» диска на «спасательный»

/dev/sda1: Moved: 0.9%

/dev/sda1: Moved: 1.8%

…

/dev/sda1: Moved: 99.7%

/dev/sda1: Moved: 100.0%

Root@work:~# vgreduce vg0 /dev/sda1 # убираю «умирающий» диск из группы томов.

Removed "/dev/sda1" from volume group «vg0»

Итого:

Я создал логический раздел, отформатировал его, примонтировал и заполнил нужными данными, затем переместил его с одного устройства на другое, при этом раздел остался примонтирован и данные всё время оставались доступны!

Подобным образом мне удавалось без перезагрузки перенести всю систему с умирающего диска на рэид-массив. :)

P.S. Прошу простить за опечатки, меня постоянно отвлекали =))

P.P.S. Ах, да!!! Самое главное и самый большой минус LVM - он не читается grub"ом

поэтому раздел /boot должен находиться вне LVM на отдельном разделе жёсткого диска,

иначе система не загрузится.

Logical Volume Manager (LVM) - это очень мощная система управления томами с данными для Linux. Она позволяет создавать поверх физических разделов (или даже неразбитых винчестеров) логические тома, которые в самой системе будут видны как обычные блочные устройства с данными (т.е. как обычные разделы). Основные преимущества LVM в том, что во-первых одну группу логических томов можно создавать поверх любого количества физических разделов, а во-вторых размер логических томов можно легко менять прямо во время работы. Кроме того, LVM поддерживает механизм снапшотов, копирование разделов «на лету» и зеркалирование, подобное RAID-1.

Если планируются большие работы с LVM, то можно запустить специальную «оболочку» командой sudo lvm . Команда help покажет список команд.

Создание и удаление

Как уже отмечалось, LVM строится на основе разделов жёсткого диска и/или целых жёстких дисков. На каждом из дисков/разделов должен быть создан физический том (physical volume). К примеру, мы используем для LVM диск sda и раздел sdb2 :

Pvcreate /dev/sda pvcreate /dev/sdb2

На этих физических томах создаём группу томов , которая будет называться, скажем, vg1 :

Vgcreate -s 32M vg1 /dev/sda /dev/sdb2

Посмотрим информацию о нашей группе томов:

Vgdisplay vg1

Групп можно создать несколько, каждая со своим набором томов. Но обычно это не требуется.

Теперь в группе томов можно создать логические тома lv1 и lv2 размером 20 Гбайт и 30 Гбайт соответствено:

Lvcreate -n lv1 -L 20G vg1 lvcreate -n lv2 -L 30G vg1

Теперь у нас есть блочные устройства /dev/vg1/lv1 и /dev/vg1/lv2 .

Осталось создать на них файловую систему. Тут различий с обычными разделами нет:

Mkfs.ext4 /dev/vg1/lv1 mkfs.reiserfs /dev/vg1/lv2

Удаление LVM (или отдельных его частей, например, логических томов или групп томов) происходит в обратном порядке - сначала нужно отмонтировать разделы, затем удалить логические тома (lvremove), после этого можно удалить группы томов (vgremove) и ненужные физические тома (pvremove).

Добавление физических томов

Чтобы добавить новый винчестер sdc в группу томов, создадим физический том:

Pvcreate /dev/sdc

И добавим его в нашу группу:

Vgextend vg1 /dev/sdc

Теперь можно создать ещё один логический диск (lvcreate) или увеличить размер существующего (lvresize).

Удаление физических томов

Чтобы убрать из работающей группы томов винчестер sda сначала перенесём все данные с него на другие диски:

Pvmove /dev/sda

Затем удалим его из группы томов:

Vgreduce vg1 /dev/sda

И, наконец, удалим физический том:

Pvremove /dev/sda

Вообще-то, последняя команда просто убирает отметку о том, что диск является членом lvm, и особой пользы не приносит. После удаления из LVM для дальнейшего использования диск придётся переразбивать/переформатировать.

Изменение размеров

LVM позволяет легко изменять размер логических томов. Для этого нужно сначала изменить сам логический том:

Lvresize -L 40G vg1/lv2

а затем файловую систему на нём:

Resize2fs /dev/vg1/lv2 resize_reiserfs /dev/vg1/lv2

Изменение размеров физического тома - задача весьма сложная и обычно не применяется. Целесообразнее и безопаснее удалить физический том, изменить размер раздела и создать том заново.

Как просто попробовать

Если LVM устанавливается не для дальнейшего использования, а «напосмотреть», то диски и разделы можно заменить файлами. Не понадобятся ни дополнительные диски, ни виртуальные машины. Мы создадим виртуальные накопители и будем с ними работать. Например, можно создать 4 диска по 1 Гбайт, но можно создать другое количество большего или меньшего размера как вам хочется. Создаем сами файлы, имитирующие устройства:

Mkdir /mnt/sdc1/lvm cd /mnt/sdc1/lvm dd if=/dev/zero of=./d01 count=1 bs=1G dd if=/dev/zero of=./d02 count=1 bs=1G dd if=/dev/zero of=./d03 count=1 bs=1G dd if=/dev/zero of=./d04 count=1 bs=1G

Создаем loopback устройства из файлов:

Losetup -f --show ./d01 losetup -f --show ./d02 losetup -f --show ./d03 losetup -f --show ./d04

Pvcreate /dev/loop0 pvcreate /dev/loop1 pvcreate /dev/loop2 pvcreate /dev/loop3 vgcreate -s 32M vg /dev/loop0 /dev/loop1 /dev/loop2 /dev/loop3 lvcreate -n first -L 2G vg lvcreate -n second -L 400M vg ...

Снапшоты

Одна из важнейших особенностей LVM - это поддержка механизма снапшотов. Снапшоты позволяют сделать мгновенный снимок логического тома и использовать его в дальнейшем для работы с данными.

Примеры использования

LVM активно используется, когда необходим механизм снапшотов. Например, этот механизм крайне важен при бекапе постоянно меняющихся файлов. LVM позволяет заморозить некоторое состояние ФС и скопировать с неё все нужные данные, при этом на оригинальной ФС останавливать запись не нужно.

Также снапшоты можно применить для организации поддержки файловым сервером с Samba механизма архивных копий, об этом в соответствующей статье:

LVM с LiveCD

Если у вас возникла необходимость работать с LVM с LiveCD Ubuntu, то вам придётся выполнить несколько дополнительных действий, поскольку по умолчанию утилит для работы с LVM нет.

Сначала вам нужно установить эти утилиты:

Sudo vgscan sudo vgdisplay YOUR_VGNAME

Sudo vgchange -a y

Эта команда должна сообщить о том, что все ваши логические тома активированы. Теперь можно работать с ними обычным образом.

На днях пришлось менять диски на сервере CentOS 6.7. Старые диски хоть и рабочие еще, но с нагрузкой не справлялись. Поэтому раскошелились и купили SSD диски такой же емкости, как и старые. Но т.к. стоимость 1 Гб на SSD диске намного дороже, то посмотрев на размер /var (180 Гб) и / (корневой раздел) 300 Гб, само собой напросилось решение увеличить размер / за счет уменьшения размера /var. Идея, конечно, хорошая, но раньше я никогда таким не баловался, поэтому провел выходные на форумах, проверил сначала все на виртуальной машине без raid, потом подумал, что на моем сервере работает софтовый raid1 и сделал тестовый стенд (на старый комп поставил CentOS 6.7 с двумя дисками в программном raid1) и проверил все на нем, потом уже выполнил повторно на рабочем сервере. Но все же волнительно было, чего уж. Итак, поехали!

Совет: если вы раньше никогда не развлекались изменениями разделов, никогда не пробуйте это делать на рабочем компьютере.

Итак, есть система из двух дисков, объединенных в raid1 (зеркало).

Разбивка примерно такая:

/dev/sda:

/dev/sda1 200 Мб, /dev/md0

/dev/sda2 480 Гб, /dev/md1

/dev/sdb:

/dev/sdb1 200 Мб, /dev/md0

/dev/sdb2 480 Гб, /dev/md1

/dev/md0 отдан под /boot

На /dev/md1 тома LVM:

/dev/VolGroup/LogVol00 swap 2 Гб

/dev/VolGroup/LogVol01 /var 180 Гб, ext4

/dev/VolGroup/LogVol02 / 300 Гб, ext4

Для чего я привел пример разбивки? Чтобы вы обратили внимание, что мы в дальнейшем ни разу не будем ресайзить тома на устройствах /dev/sdXY. Мы все изменения разделов будем проводить только с логическими томами LVM!

Задача: изменить размер /var до 30 Гб и отдать все освободившееся место в / (корень). Файловая система обоих разделов ext4. Система CentOS 6.7.

Шаг 1: уменьшаем /var

В моем случае (софтовый raid1) я сначала проверил на всякий случай, что все диски подключены и ошибок нет (cat /proc/mdstat).

Я не был уверен, что размонтировать /var (umount /var) в рабочем режиме хорошая мысль, поэтому загрузился с LiveCD CentOS в Rescue Mode (можно было войти в single mode и без LiveCD).

Проверяем доступность физического тома LVM:

# pvscan

PV /dev/md1 VG VolGroup lvm2

Проверяем доступность групп томов:

# vgscan

Reading all physical volumes. This may take a while...

Found volume group "VolGroup" using metadata type lvm2

Активируем логические тома:

Смотрим логические тома:

# lvscan

ACTIVE "/dev/VolGroup/LogVol01" inherit

ACTIVE "/dev/VolGroup/LogVol00" inherit

ACTIVE "/dev/VolGroup/LogVol02" inherit

Можно посмотреть подробности тома /dev/VolGroup/LogVol01 (он у нас /var):

# lvdisplay /dev/VolGroup/LogVol01

а можно и не смотреть.

Все вышеуказанные проверки служат для того, чтобы вы были уверены, что тома LVM видны и активны и чтобы вы понимали, с каким именно томом вам следует проводить дальнейшие дествия. Идем дальше.

Отмонтируем том, который у нас /var и который будет уменьшать:

# umount /dev/VolGroup/LogVol01

Выполняем проверку файловой системы тома:

# fsck.ext4 /dev/VolGroup/LogVol01

Команда должна пройти без ошибок.

Выполняем проверку на наличие ошибок (-f - force):

# e2fsck -f /dev/VolGroup/LogVol01

Сначала уменьшаем размер файловой системы тома:

resize2fs -p /dev/VolGroup/LogVol01 30G

Внимание: здесь "30G" - это размер, который мы хотим задать для файловой системы, а не на который мы хотим уменьшить файловую систему.

И только после этого изменяем размер тома LVM:

# lvreduce -L 30G /dev/VolGroup/LogVol01

Получили сообщение об успешном завершении.

Теперь можно и не монтировать обратно раздел, а сразу перезагрузиться и проверить, что все ок, система загружается, df -h выдает размер /var равным 30 Гб.

На CentOS после загрузки до входа в систему появилось сообщение от SELinux, который должен переиндексировать изменения. Ок. Это заняло какое-то время и система сама перезагрузилась. После этого я вошел в систему и убедился, что все ок. Только после этого я перешел ко второму шагу (который оказался намного быстрее и проще), а именно увеличению корневого раздела путем добавления к нему всего доступного свободного места на физическом томе LVM. Заупстите pvscan и посмотрите, в выводе команды будет указано, есть доступное место (это плюс-минус то, что было занято раньше под /var). Теперь мы это свободное место добавим к / (корню).

Шаг 2: увеличиваем размер тома LVM (который у нас /) без перезагрузки

Да, вы не очитались. Чтобы увеличить размер тома LVM нам не придется загружаться в single mode (или через LiveCD в Rescue mode).

На всякий случай, чтобы не перепутать, какому тому вы хотите отдать свободное место, выполните cat /etc/fstab и lvscan, убедитесь, что раздел / (корень) - это /dev/VolGroup/LogVol02, а не что-то иное;)

# lvextend -l+100%FREE -r

Именно так, без пробелов между -l (это маленькая L) и +100%FREE. Заметьте, я не стал указывать, на сколько точно я хочу увеличть размер тома. В данной ситуации мне это было не нужно и чтобы не гадать, сколько конкретно надо добавить Гбайт, я просто указал, чтобы было добавлено все, что можно. man lvextend для ознакомления с вариациями -L+100G ;) Опция -r указывает на то, чтобы был выполнен ресайз файловой системы после увеличения логического тома. Без этой опции команды было бы две:

# lvextend -l+100%FREE /dev/VolGroup/LogVol02

# resize2fs /dev/VolGroup/LogVol02

После успешного завершения я бы перезагрузился и проверил, что все ок.

Естественно, все вышеописанное может дать сбой на любом этапе, хотя бы из-за сбоя электропитания. Поэтому если данные на изменяемых разделах хоть как-то важны, вы должны иметь их копию.

Все вышеперечисленное верно для CentOS. Для Ubuntu вроде бы все то же самое. Думаю (не знаю) что для всех современных Linux все команды такие же.

21.08.2017 10:48 bzzz

Менеджер логических томов (Logical Volume Manager) - менеджер логических томов операционных систем GNU/Linux и OS /2. Она позволяет создавать поверх физических разделов (или даже неразбитых винчестеров) логические тома, которые в самой системе будут видны как обычные блочные устройства с данными (т.е. как обычные разделы). Основные преимущества LVM в том, что во-первых одну группу логических томов можно создавать поверх любого количества физических разделов, а во-вторых размер логических томов можно легко менять прямо во время работы. Кроме того, LVM поддерживает механизм снапшотов, копирование разделов «на лету» и зеркалирование, подобное RAID -1.

Создание и удаление LVM

Для LVM существует три группы утилит, предназначенных для работы с физическими томами (pv*), логическими группами (lg*) и логическими томами (lv*). Так, команда pvcreate создает физические тома, команда pvscan - сообщает об наличествующих, а команда pvdisplay выводит о них полную информацию. А тройки команд vgcreate, vgscan, vgdisplay и lvcreate, lvscan, lvdisplay проделывают то же для групп томов и логических томов, соответственно.

Удаление LVM (или отдельных его частей, например, логических томов или групп томов) происходит в обратной последовательности их создания:

отмонтируем разделы (umount)

lvdisplay. удалить логические тома (lvremove)

vgdisplay. удалить группы томов (vgremove) # vgremove vz

pvdisplay. удалить ненужные физические тома (pvremove) # pvremove /dev/sda3

Создание LVM

Создать физический том (physical volume) на разделе sda3: # pvcreate /dev/sda3 # pvdisplay

На физическом томе создаём группу томов, с именем vz: # vgcreate -s 32M vz /dev/sda3

Команда vgcreate запускается с именем группы в качестве первого аргумента и имени файла устройства раздела - как аргумента второго. Имя группы - произвольно, в путях к файлам устройств физических томов при использовании devfs должна применяться полная нотация (как это вывела команда pvscan). По умолчанию тома нарезаются на физические блоки extent"ы размером 4 Мбайт. При желании иметь другой размер блока - это можно явно задать опцией -s ##m. Рекомендуется использовать extent"ы в 32 Мбайт, в этом случае максимальный размер любого из будущих логических томов ограничивается величиной 2 терабайта, если же остановиться на умолчальном extent"е, предел тома составил бы 256 Гбайт.

Создание логического тома или томов (аналог нарезания на разделы физического жесткого диска). Создадим два раздела tmp размером 10Гб и раздел rest, который займет все оставшееся пространство группы томов vz: # lvcreate -l 10G -n tmp vz # lvcreate -l 100%FREE -n rest vz

Отформатируем получившиеся логические тома: # mkfs.ext4 /dev/vz/tmp # mkfs.ext4 /dev/vz/rest

На моем домашнем сервере Linux установлен диск на 250 ГБ. Я только что купил новый 250 ГБ SATA-диск, и я хочу добавить новый диск в мой существующий том LVM, чтобы увеличить его размер до 500 ГБ. Как добавить диск в LVM и расширить объем LVM в операционной системе Linux?

Управление томами Linux (LVM) создает простой в использовании уровень поверх физических дисков. Вы можете комбинировать несколько дисков и создавать логические тома хранилища. Это обеспечивает конкретные преимущества, такие как:

- Никаких ограничений на размер диска;

- Увеличена пропускная способность диска

- Объемы зеркалирования для критически важных бизнес-данных;

- Снимки тома;

- Легкое резервное копирование и восстановление с использованием моментальных снимков;

- Простое перемещение данных;

- Изменение размеров пулов хранения (добавление или удаление дисков) без обязательного переформатирования дисков.

Шаг 1 – Узнать информацию о существующих LVMВнимание : Будьте осторожны с lvm / mkfs.ext4 и другими командами, а также с именами устройств, т.к. если имя устройства задано неверно, это может уничтожить все данные. Соблюдайте осторожность и всегда держите полные резервные копии.

Управление хранилищем LVM разделено на три части:

- Физические тома (ФТ(PV)) – фактические (например, /dev/sda, /dev,sdb, /dev/vdb и т.д.)

- Группы томов (ГТ(VG)) – физические тома объединяются в группы томов. (например, my_vg = /dev/sda + /dev/sdb .)

- Логические тома (ЛТ(LV)) – группа томов, в свою очередь, делится на логические тома (например, my_vg делится на my_vg/data, my_vg/backups, my_vg/home, my_vg/mysqldb и т.д.)

Как отобразить информацию о физических томах (pv)

Введите следующую команду pvs, чтобы просмотреть информацию о физических томах:

Итак, в настоящее время мой LVM включает физический том (фактический диск), называемый /dev/vda5 . Чтобы просмотреть подробную информацию о свойствах, введите:

$ sudo pvdisplay

Примеры возможных выводов данных:Из вышеуказанного вывода ясно видно, что наша группа томов с именем ubuntu-box-1-vg сделана из физического тома с именем /dev/vda5 .

Как отобразить информацию о LVM группе томов (vg)

Введите любую из следующих команд vgs/vgdisplay vgs , чтобы просмотреть информацию о группах томов и их свойствах:

$ sudo vgdisplay

Примеры возможных выводов данных:Как отобразить информацию о LVM логическом томе (lv)

Введите любую из следующих команд lvs command / lvdisplay , чтобы просмотреть информацию о группах томов и их свойствах:

$ sudo lvdisplay

Примеры возможных выводов данных:Моя группа томов ubuntu-box-1-vg разделена на два логических тома:

- /dev/ubuntu-box-1-vg/root – корневая файловая система;

- /dev/ubuntu-box-1-vg/swap_1 – пространство для свопинга.

Шаг 2 – Узнайте информацию о новом диске

Вам нужно добавить новый диск на свой сервер. В этом примере для демонстрационной цели я добавил новый диск, который имеет размер 5GiB. Для того чтобы узнать информацию о запуске новых дисков:

$ sudo fdisk –l

$ sudo fdisk -l | grep "^Disk /dev/"

Примеры возможных выводов данных:Другой вариант – сканировать все видимые устройства для LVM2:

$ sudo lvmdiskscan

Примеры возможных выводов данных:/dev/ram0 [ 64.00 MiB] /dev/ubuntu-box-1-vg/root [ 37.49 GiB] /dev/ram1 [ 64.00 MiB] /dev/ubuntu-box-1-vg/swap_1 [ 2.00 GiB] /dev/vda1 [ 487.00 MiB] /dev/ram2 [ 64.00 MiB] /dev/ram3 [ 64.00 MiB] /dev/ram4 [ 64.00 MiB] /dev/ram5 [ 64.00 MiB] /dev/vda5 [ 39.52 GiB] LVM physical volume /dev/ram6 [ 64.00 MiB] /dev/ram7 [ 64.00 MiB] /dev/ram8 [ 64.00 MiB] /dev/ram9 [ 64.00 MiB] /dev/ram10 [ 64.00 MiB] /dev/ram11 [ 64.00 MiB] /dev/ram12 [ 64.00 MiB] /dev/ram13 [ 64.00 MiB] /dev/ram14 [ 64.00 MiB] /dev/ram15 [ 64.00 MiB] /dev/vdb [ 5.00 GiB] 2 disks 18 partitions 0 LVM physical volume whole disks 1 LVM physical volume

Шаг 3 – Создание физических томов (pv) на новом диске под названием /dev/vdbВведите следующую команду:

$ sudo pvcreate /dev/vdb

Примеры возможных выводов данных:Physical volume "/dev/vdb" successfully created

Теперь выполните следующую команду для проверки:

$ sudo lvmdiskscan –l

Примеры возможных выводов данных:WARNING: only considering LVM devices /dev/vda5 [ 39.52 GiB] LVM physical volume /dev/vdb [ 5.00 GiB] LVM physical volume 1 LVM physical volume whole disk 1 LVM physical volume

Шаг 4 – Добавление недавно созданного физического тома (pv) с именем /dev/vdb в существующий логический том (lv)Введите следующую команду для добавления физического тома /dev/vdb в группу томов «ubuntu-box-1-vg».